Super Mario Level mit HoloLens

23.06.2017

Der Künstler Abhishek Singh hat den ersten Level von Super Mario für die Microsoft HoloLens erstellt. Im Central Park New York hüpft und läuft er durch die Map. Neben dem Einsammeln von Power Ups kann der Spieler auch auf die Gegner hüpfen. Ganz wie im Original ist auch das Schießen von Feuerbällen implementiert. Ich freue mich darauf wenn diese Spiele endlich Marktreif werden. Vielleicht kann man dann irgendwann Pokemon in einer schönen Variante einsammeln oder bei Yu-Gi-Oh!

Weiterlesen… ( ~1 Min.)Google Assistant API für Raspberry Pi

28.04.2017, 02.01.2020

Seit gestern gibt es die developer preview (alpha v1) der Google Assistant API zur freien Verfügung. Auf der Developer Webseite sind neben der Ankündigung einige Samples veröffentlicht. Der in Python geschriebene Code steht auch für den Raspberry Pi zur Verfügung. Google Assistant Der Google Assistant ist ein persönlicher Assistent von Google für Android, Google Home und den Messenger Google Allo, der sowohl gesprochene als auch eingegebene natürliche Sprache empfängt und verarbeitet.

Weiterlesen… ( ~1 Min.)Starcraft 2: Schnittstelle für Deep-Learning-Intelligenz ab Sommer 2017 | heise online

27.04.2017

Blizzard arbeitet zusammen mit der Firma DeepMind zusammen mit dem Ziel Starcraft 2 eine API zur Verfügung zu stellen, mit dessen Hilfe sich Künstliche Intelligent entwickeln lässt. Die Google-Tochter DeepMind hat in der Vergangenheit bereits Schlagzeilen gemacht als sie mit ihrem AlphaGo System das Go Spiel ernsthaft bespielte.

Weiterlesen… ( ~1 Min.)

Drupal zu WordPress

21.04.2017

Seit heute präsentiert sich SPech.de in einem völlig neuen Design und einer neuen Technologie. Das langjährig genutzt Drupal ist WordPress gewichen. Warum dieser Wechsel der mich doch einige Wochen beschäftigt hat?

Weiterlesen… ( ~2 Min.)

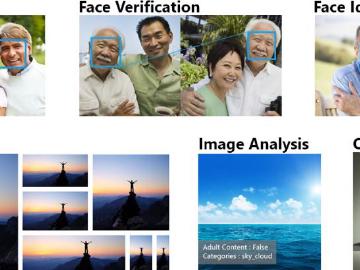

Raspberry Pi Gesichtserkennung mit Microsoft Cognitive Services

17.03.2017

Microsoft stellt mit den Microsoft Cognitive Services eine Reihe von Services für Bilderkennungsverfahren zur Verfügung. Die Face API bildet eine gute Schnittstelle um dem Raspberry Pi die Gesichtserkennung zu ermöglichen. Mit Hilfe einer Webcam und etwas JavaScript und Node.js lassen sich Bilder aufnehmen und zur Analyse hochladen. Der Cloud-Dienst ist dabei bis zu einer gewissen Menge von Abfragen kostenlos nutzbar.

Weiterlesen… ( ~3 Min.)

Parrot AR Drone 2.0 mit Raspberry Pi steuern

07.03.2017, 02.01.2020

Die Parrot AR.Drone 2.0 Power Edition ist schon etwas älter, aufgrund der hervorragenden Entwicklungsumgebungen eignet sich der Quadrocopter jedoch sehr gut für ein Projekt mit dem Raspberry Pi. Im Folgenden soll die Steuerung mit Hilfe von, auf Node.js aufbauenden, Skripten erfolgen. Für das Fliegen über den Minicomputer sind keine Vorerfahrungen notwendig. Der Copter stabilisiert sich eigenständig in der Luft und die Kommunikation erfolgt direkt über WLAN. Das Linux Betriebssystem des Quadrocopter ist in Teilen konfigurierbar. Außerdem verfügt das Gerät über zwei Kameras welche sich zur Gesichtserkennung oder für Videoaufnahmen eignen.

Weiterlesen… ( ~4 Min.)